阅读:0

听报道

文 | 魏子敏、蒋宝尚

今天,英伟达2019GPU 技术大会(GTC19)在美国加利福尼亚州圣何塞举行。在这一严重拖堂、长达2小时40分钟的Keynote演讲中,英伟达创始人兼首席执行官黄仁勋火力全开,宣布了该公司在软件、机器学习平台,以及自动驾驶上的一系列新动作。

大数据文摘对其演讲的核心内容做了梳理,先来看看整场发布会最让人精神振奋的部分——AI游乐场。

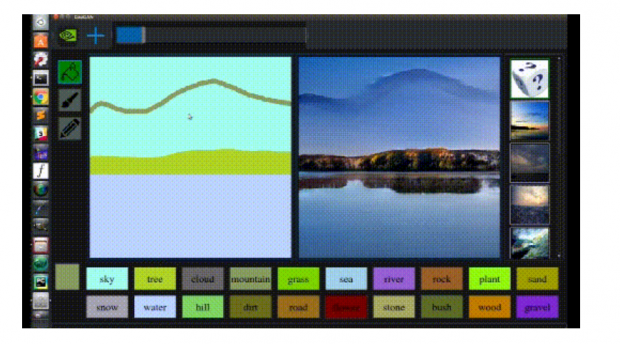

英伟达“游乐场”:正式发布“马良神笔”GauGAN,草图生成高清大图。

草草画几笔就能变成超真实的画面。这一之前只在论文中出现就火爆了社交圈的“神仙操作”今天终于在大会现场实操发布了。

黄教主亲自操刀展示了这项技术的工作原理。他使用画笔在画布上简单的描绘,然后模型在输出图像的相应位置生成了真实的图像。生成的内容与场景其余部分毫无违和感,简直是马良神笔啊。

这是英伟达在本次大会上发布的其最新的图像处理研究成果GauGAN——一种基于生成式对抗网络的技术,能够将分割的图片转换成真实的照片。

其实,GauGAN的研究论文已被CVPR 2019作为口头报告收录,并且因为其强大的功效早已在社交圈火了一把。

英伟达称,GauGAN的相关研究是在之前pix2pixHD基础上进行的改进,新模型的参数较少,可生成的图像选项较多。训练数据是英伟达从Flickr收集的,包含100万张图片。

该模型允许用户更改生成的图像,例如将白天场景更改为日落,等等。

英伟达这一研究的效果与去年11月由麻省理工学院(MIT)、IBM、谷歌和香港中文大学研究人员合力发表的一篇论文相似。在论文中,其提出的GANPATE可以使任何人都能画出极其复杂和详细的“真实”场景。这两篇论文几乎是同时提出的,但采用了不同的技术,并被设计用于不同的场景。

虽然GauGAN仍然是一个概念的证明,但该技术在游戏、电影制作和许多其他视觉展示领域有潜在的应用前景。例如,游戏设计者可以利用该技术更快、更有效地呈现更真实的模拟环境。

今天在大会首次亮相的还有Nvidia AI Playground(英伟达AI游乐场),这是一个综合性AI训练网站,人们可以在这里完成各种神经网络的训练,包括今天大会现场演示的把草稿变成图片的GauGAN。

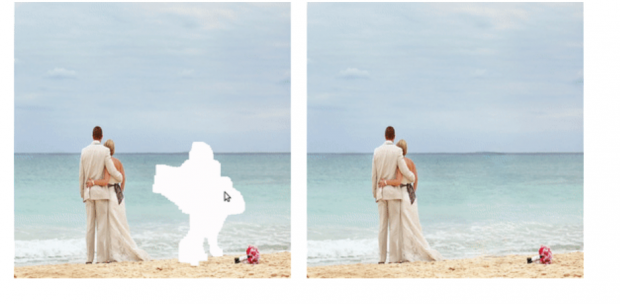

之前大火的神奇照片修复功能。

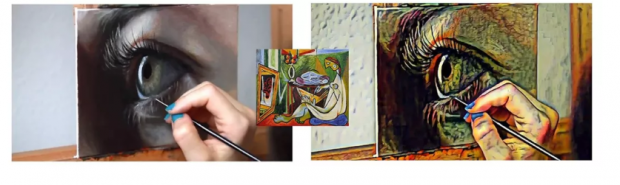

神奇的艺术风格转化效果。

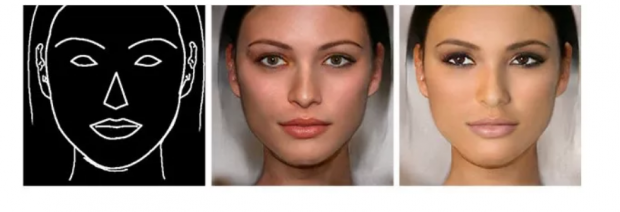

以及面部图像合成器。

这些酷炫的效果让凌晨5点起床看发布会的文摘菌一扫困倦,被称为“游乐场”确实名副其实。感兴趣的同学可以去玩一下

当然,除了好玩的“游乐场”平台,英伟达也在本次发布会发布了几个硬货。

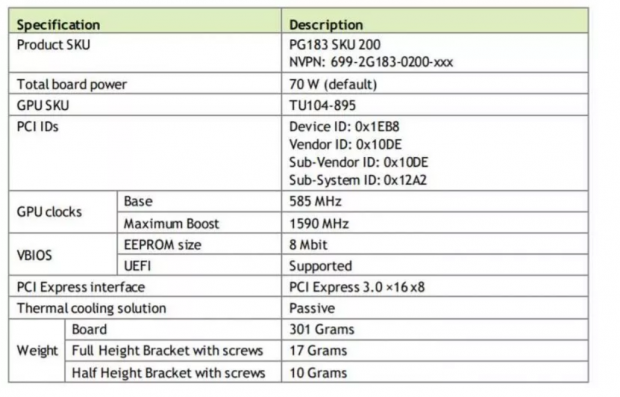

发布新的Tesla T4芯片

虽然消费市场尚未大规模普及,但英伟达依然将其作为一个重点领域孜孜不倦的开发,其在本次峰会上最新发布了一款Tesla T4芯片。

黄教主在大会上表示,第二代基于Tensor Core的GPU硬件“过时”了,其最新Tesla T4芯片具有64GB的GDDR6超快速VRAM内存,同时在可部署的服务器安装中使用4x T4卡。使得分布式计算的速度大大加快,将“超大规模”计算降集成到了机架式(a rack mount)。

英伟达 T4 GPU加速了各种云工作负载,包括高性能计算、深度学习训练和推理、机器学习、数据分析。基于新的图灵™架构,只消耗能源70W,可谓非常节能。另外,T4优化主流计算环境,并具有多精度图灵张量核心和新的RT核心。结合NVIDIA GPU Cloud(NGC)的加速容器化软件栈,T4在规模上提供颠覆式的性能。

总的来说,该卡采用单插槽设计,只有6.6英寸长,并使用PCIe Gen3。 使用新的TU104 Nvidia GPU,16 GB GDDRT6和仅70W的最大功率限制意味着它可以轻松散热。 另外其支持8x和16x PCIe。

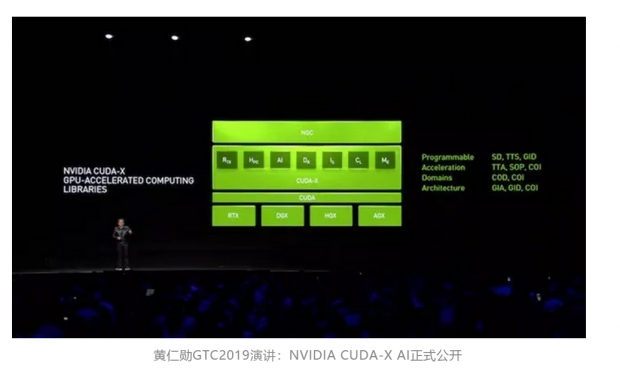

CUDA X AI平台公开,发布专为数据科学发布的新一代集成工作站

本次发布会上,英伟达推出了端到端机器学习平台CUDA-X AI平台。

英伟达称,NVIDIA CUDA-X AI正在改变数据科学,提高开发人员的工作效率,加速深度学习,机器学习和数据分析的工作流程,它已集成到主要的深度学习框架中,如TensorFlow,PyTorch和MXNet,并且已经被Charter,Microsoft,PayPal 和Walmart等顶级公司所使用。

英伟达称,CUDA-X AI广泛可用。其软件加速库集成到所有深度学习框架中,包括TensorFlow,PyTorch和MXNet,以及流行的数据科学软件,如RAPIDS。也可适用各类云平台,包括AWS,Microsoft Azure和Google Cloud。CUDA-X AI库可以部署在NVIDIA GPU上的任何地方,包括台式机,工作站,服务器,云计算和物联网(IoT)设备。

上周,Nvidia正式宣布以69亿美元的超高价格收购了Mellanox,可以看出数据中心对英伟达未来的重要性。

本次峰会上,英伟达也专门为数据科学工作者推出了新一代集成工作站。黄教主称,数据从根本上改变了公司的业务方式,推动了对数据科学家的需求,并增加了工作流程的复杂性。但数据科学家的时间非常昂贵,他们开发模型所需的计算资源需求量很大。如果他们花费数小时甚至数天从源头编译框架只是为了发现错误,那就是生产力,收入和竞争优势的损失。

成千上万的数据科学家和开发人员已经推出了性能优化的深度学习框架容器,如TensorFlow和PyTorch,辅助跳过耗时且容易出错的部署步骤,专注于构建他们的解决方案。

英伟达本次扩展了NGC软件中心,为数据科学家提供了更快地构建优化解决方案的工具,黄教主称,不同行业需要定制的流程和软件,NGC目前已经为智能城市和医学成像提供了行业特定的工作流程。

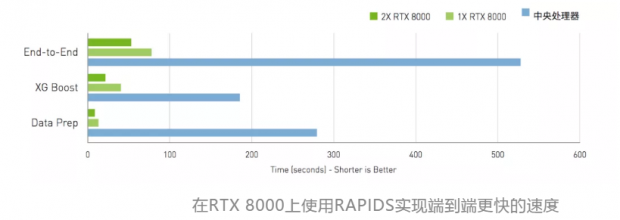

同时,英伟达将Quadro RTX GPU的强大功能与加速的CUDA-X AI数据科学软件相结合,为数据科学提供新一代完全集成的工作站。

这一数据科学工作站配备了一整套经过测试和优化的数据科学软件。该堆栈具有RAPIDS数据处理和机器学习库,英伟达优化的TensorFlow,PyTorch,Caffe 和其他领先的数据科学软件,为企业提供加速工作流程,以加快数据准备,模型培训和数据可视化。

结合Quadro RTX GPU的强大功能与RAPIDS的加速相结合,英伟达希望通过这一工作站缩短模型训练时间并提供最快的数据科学解决办法。

迷你机器人开发插件Jetson Nano:售价99美元

本次大会上,黄仁勋也正式发布了机器人开发者工具箱Jetson Nano,可以为机器人设计引入AI算力。

Jetson Nano是一款类似于树莓派的嵌入式电脑设备,其搭载了四核Cortex-A57处理器,GPU则是拥有128个NVIDIA CUDA核心的NVIDIA麦克斯韦架构显卡,内存4GB LPDDR4,存储则为16GB eMMC 5.1,支持4K 60Hz视频解码。

Jetson Nano支持高分辨率传感器,可以并行处理多个传感器,并可在每个传感器流上运行多个现代神经网络。它还支持许多流行的AI框架,使开发人员可以轻松地将他们喜欢的模型和框架集成到产品中。

Jetson Nano有两个版本 - 面向开发人员,制造商的99美元开发套件以及面向希望创建大众市场边缘系统的129美元生产就绪模块,将于6月开始发货。两者都将通过NVIDIA的主要全球分销商进行销售。开发人员套件也可以从制造商渠道,Seeed Studio和SparkFun购买。

使用Unity引擎进行实时光线跟踪,已应用于汽车设计

光线追踪是英伟达 RTX平台的杀手锏,其一直也是GPU领域关注的焦点。英伟达正在大力推进光线追踪。

在今天的GTC大会上,英伟达宣布与Unity Technologies合作,通过Unity的高清晰渲染管线(HDRP)为Unity Engine带来实时光线跟踪,预计在2019年下半年会公布。

Unity副总裁Natalya Tatarchuk称:在去年英伟达推出了高清晰度渲染管道的预览版,能够在消费硬件上实时实现惊人的图形效果。这次与英伟达公司合作,RTX实时光线跟踪功能很快就能将这项技术普及。“

Unity Technologies将Nvidia RTX光线跟踪3D技术应用于汽车设计。在会上,为了展示光线追踪功能,英伟达播放了宝马8系列跑车的视频,更加强调了RTX带来的真实性。

光线跟踪包含在像Unity Engine这样的开放平台中,是实现光线跟踪的重要一步。此外,在大会上英伟达宣布推出一系列GeForce GTX系列显卡的“基本RT效果”和“低光线数(low ray count)”功能。

不过,这一功能对硬件要求也比较高,用户至少需要配置一个6GB的GeForce GTX 1060。所有Pascal GPU都可以通过TITAN Xp使用基本的RT功能,包括新的基于图灵架构的GeForce GTX 1660和GTX 1660 Ti显卡。要求高功效和多重RT效果,就需要GeForce RTX 2060,2070,2080,2080 Ti和TITAN RTX等芯片了。

推出全新开放交互式3D设计协作平台——NVIDIA Omniverse

此外,英伟达还推出了一款功能强大的全新开放交互式3D设计协作平台——NVIDIA Omniverse。它适用于由NVIDIA RTX提供支持的3D制作流程。

这是一个开放式协作平台,可简化实时图形的工作室工作流程。包括门户 - 双向隧道 - 维护行业标准应用程序(如Autodesk Maya,Adobe Photoshop和Epic Games的虚幻引擎)之间的实时连接。

这个新的开放式协作平台简化了跨行业的2D和3D产品管道。Omniverse围绕最新的设计协作行业标准而构建,支持Pixar的通用场景描述技术,用于在多个应用程序之间交换有关建模,着色,动画,灯光,视觉效果和渲染的信息。它还支持NVIDIA的材料定义语言,允许艺术家跨多个工具交换有关表面材料的信息。

推出NVIDIA DRIVE Constellation仿真平台

最后,黄教主也宣布了英伟达在无人驾驶平台上的新动作——推出NVIDIA DRIVE Constellation仿真平台。

DRIVE Constellation是一个数据中心解决方案,包括两个并排服务器。DRIVE Constellation由两个并排的服务器组成,可实现位精确的实时仿真。第一台服务器 - DRIVE Constellation Simulator - 从虚拟汽车生成传感器输出;第二台服务器 - DRIVE Constellation Vehicle - 包含DRIVE AGX Pegasus AI车载电脑。DRIVE AGX Pegasus接收传感器数据,做出决定,然后将车辆控制命令发送回模拟器。这种闭环过程可实现位精确,定时精确的硬件在环测试。

可以选择任何天气、时间模拟驾驶

英伟达称这种基于云的解决方案可以在虚拟环境中驱动数百万英里的各种场景,从常规驾驶到罕见甚至危险情况,比现实世界中的效率,成本效益和安全性更高:3000辆车可以每年驾驶超过10亿英里,且每公里的驾驶都包括罕见或危险场景。

在GTC主题演讲阶段,黄教主演示了DRIVE Constellation平台如何执行驾驶测试。DRIVE Constellation用户可以通过云远程访问任何平台。开发人员可以提交一个特定的模拟场景。例如,在潮湿的道路上雾蒙蒙的夜晚,一辆自动驾驶汽车对另一辆汽车在交通繁忙时切入车道作出反应。

DRIVE Constellation是一个开放式平台,意味着它提供了一个编程接口,允许DRIVE Sim生态系统合作伙伴集成他们的环境模型,车辆模型,传感器模型和交通场景。通过整合各种合作伙伴,该平台可以生成全面,多样化和复杂的测试环境。

英伟达宣布,已经与最大的汽车生产商之一——丰田达成合作。丰田研究院,高级开发(TRI-AD)将使用DRIVE Constellation,并扩大双方合作。TRI-AD将利用该平台加速自动驾驶汽车的开发和生产时间表,模拟在具有挑战性的情况下相当于数十亿英里的驾驶。

话题:

0

推荐

财新博客版权声明:财新博客所发布文章及图片之版权属博主本人及/或相关权利人所有,未经博主及/或相关权利人单独授权,任何网站、平面媒体不得予以转载。财新网对相关媒体的网站信息内容转载授权并不包括财新博客的文章及图片。博客文章均为作者个人观点,不代表财新网的立场和观点。

京公网安备 11010502034662号

京公网安备 11010502034662号