阅读:0

听报道

作者:魏子敏、周素云

这是人类历史上第一次,直接从大脑中输出完整的口语句子。

4月25日, Nature杂志发表了一项新成果, 神经科学家设计了一种可以将大脑信号转换为语音的设备。通过最先进的脑机界面,根据大脑活动控制的虚拟声道来产生自然合成的合成语音。简单来说,就是通过解码人类嘴唇、下巴、舌头和喉头等脑信号,将其转换成患者想表达的语音。

“这是第一次,我们可以根据个人的大脑活动生成完整的口语句子。” 加州大学旧金山分校神经外科教授,也是该成果的主要研究员Edward Chang说。

语音障碍者广泛存在。由于各类事故、中风或神经退行性疾病(如肌萎缩侧索硬化症或肌萎缩侧索硬化症)中受伤而导致言语能力丧失,成千上万的人无法进行正常的交流。

用外部设备生成辅助语音输出早已有之。我们之前所熟知的,例如霍金使用的语音合成器,是通过人类眼睛和面部动作来拼写单词,在理想情况下,可以帮助瘫痪者每分钟输出多达 8 个单词。

这些技术已经给失语患者带来了一些生活改善,但与自然语音每分钟150 个单词的平均速度比起来,通过外部接口进行输出的速度还是太慢了。

Nature最新发布的这项实验成果则将沟通恢复能力直接提升了一个层级:直接读取大脑信号合成语音。相比逐字录入,更加高效,并且可以解决现有技术语音输出的很多问题,比如靠单个音节蹦字导致的语音语调缺失。如果可以应用到临床,可以大大改善语音障碍患者的沟通能力。

Edward Chang团队也放出了一段清晰可理解的语音例子:前半部分是参与实验的阅读者读出的句子,后半部分是通过记录患者大脑活动,自动产生的句子的。

尽管脑电波产生的内容相比自然语音依然颇为模糊,但是已经是整句的输出,并且保留了句子的断句感和语调。据该研究称,多达70%的英语母语测试者认为可以听懂相关内容。

其实去年年初,Science杂志也报道过Edward Chang团队在脑机接口上作出的重要进展,当时的研究还停留在单个数字的记录上:研究者让测试者听口述数字,并基于其听到数字时脑活动的记录,进行电脑重建语音。当时的数字虽然也可辨认,但是只停留在单个词语的输出。

而对比最新放出的音频,仅仅一年多的时间,已经可以输出完整的语句了。据Edward Chang称,这一技术目前已经“触手可及”,“我们应该能够在失去语言能力的患者中,构建一种具有临床可行性的设备。”

论文下载链接:

解读大脑意图,然后生成语音

对于因神经损伤而无法沟通的人来说,将神经活动转化为语言的技术将具有变革性的意义。

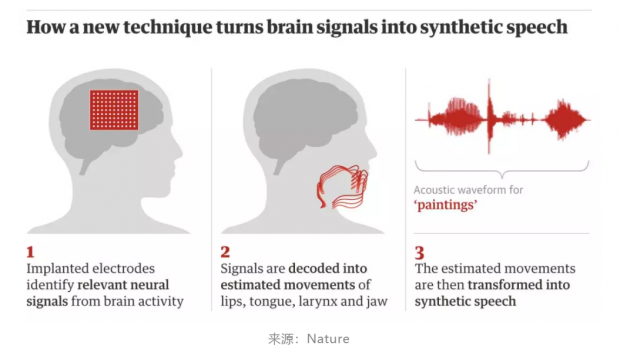

从神经活动中解码语音是具有挑战性的,因为说话需要对声道咬合架进行非常精确和快速的多维控制。Chang教授他们设计的神经解码器,明确地利用人类皮质活动中编码的运动和声音表示来合成可听语音。递归神经网络首先将记录的皮质活动直接解码为关节运动的表示,然后将这些表示转换为语音声学。

在封闭的词汇测试中,听众可以很容易地识别和转录从皮层活动合成的语音。即使数据有限,中间关节动力学也能提高性能。这些发现提高了使用语音神经假体技术恢复口语交流的临床可行性。虽然,此次实验是在具有完整语言功能的志愿者中进行,但在未来,该技术有望恢复由于瘫痪和其他形式的神经损伤而失去说话能力的人的声音。

实验过程

该团队招募了五名即将接受癫痫神经外科手术的志愿者。为了准备手术,医生们在大脑中暂时植入电极来绘制患者癫痫发作的来源。当电极就位时,志愿者被要求大声读出数百个句子,而科学家则记录了已知涉及言语产生的大脑区域的活动。

仅需两步即可解码语音:将大脑中的电信号转换为声音运动,然后将这些运动转换为语音。

他们不需要收集第二步的数据,因为其他研究人员之前已经编制了一个大型数据库,显示了声音运动与语音的关联。他们可以用它来逆向设计患者的声音运动。

然后,他们训练机器学习算法,以便能够将大脑中的电活动模式与这将产生的声音运动相匹配,例如将嘴唇压在一起,收紧声带并将舌尖移到嘴的顶部。他们将这项技术描述为“虚拟声道”,可以直接由大脑控制,从而产生与人声的合成近似。

为了测试合成语音的可懂度,科学家们通过亚马逊Mechanical Turk平台,邀请了数百人进行样本转录。

在测试中,每次给出100个句子和25个单词,包括目标词和随机词。听众辨识的准确率达43%。

一些发音,如“sh”和“z”被精确合成,对于“b”和“p”的发音解码器还不能完全分清。

但这些并不影响正常地沟通,在日常生活中,我们也会渐渐熟悉一个人的发音方式,并对他们想要表达的话进行推测。

目前,该实验算法还不能解码未经训练的句子, 要成为一个可行的临床语言合成脑机接口,还有很长的路要走。

脑机接口相关探索

其实早在去年年初,Science杂志就报道过Edward Chang团队以及来自哥伦比亚大学(Columbia University)和德国不莱梅大学(Bremen)在脑机接口上作出的重要进展:通过手术,他们在大脑上放置电极,搜集电极产生的数据,再将其通过计算机变成语音信息;接着通过神经网络模型,他们重建了在某些情况下,可以被人类听众所理解的单词和语句。

当时,来自哥伦比亚的研究者试图找出在不同时间点,大脑打开与关闭神经元的模式,并由此推断语音内容。虽然这些模型将在非常精确的数据上表现最好——而搜集这些精准的数据需要打开我们的头盖骨。

研究人员只能在极少数情况下才会进行此类危险性记录:一种情况是在移除脑肿瘤期间,暴露在外的大脑产生的电读数能够帮助外科医生定位以避开关键的语音及运动区;另一种情况是在手术前为癫痫患者植入电极并保持数天以确定癫痫发作起因。

当时,Edward Chang就和他的团队,根据由三名癫痫患者大声朗读语音引起的、从语言及运动区域捕获的大脑活动,重建了整个句子。

在线上测试中,有166人听懂了其中一个句子,并从10项文字选项中进行选择。超过80%的情况下模型都能够正确识别句子。研究人员还进一步改进了模型:他们使用它根据人类的唇语来重新创建句子。

当时的研究者也放出了一段实验录音,他们让一组听众会在计算机“说出”数字同时对其进行评估;其精确度大约为75%。声音听起来有些可怕,但是仔细听仍可以辨认出数字。

此外,钢铁侠“马斯克”也对这个领域颇感兴趣,除了电动车和太空探索,他也早早涉足了脑机接口这个领域,2016年创立了脑机接口研发公司Neuralink,与多位加州大学知名神经科学家合作,其短期目标是治愈严重的脑部疾病,如老年痴呆症和帕金森症,并且最终通过“与AI的融合”来增强大脑。

被人工智能、神经学和语言学共同推动的人类进步

该项目的研究人员目前正在试验更高密度的电极阵列和更先进的机器学习算法,他们希望这些算法能够进一步改善合成语音。该技术的接下来的目标,是将这个系统应用到一个不会说话的人身上,在无法用他们自己的声音进行训练的前提下,测试是否可以学习如何使用该系统,并将其推广,让他们能够说出想说的任何内容。

该团队的一位研究参与者表示,研究人员基于解剖学可以解码和合成来自参与者大脑活动的新句子,以及算法训练的句子。即使研究人员提供了记录大脑活动数据的算法,而一个参与者只是在没有声音的情况下讲话,系统仍然能够在说话者的声音中产生可理解的合并版本的混合句子。

研究人员还发现,声音运动的神经代码在参与者之间部分重叠,并且一个研究对象的声道模拟可以响应从另一个参与者的大脑记录的神经指令。总之,这些研究结果表明,由于神经功能障碍导致语言障碍的个体,很有可能学会使用这个系统,并以录入声音为模型的语音假体。

“肢体残障者人已经学会用大脑控制机器人肢体,”Chang实验室的生物工程研究生Chartier说。“我们希望有一天,有语言障碍的人能够学会用这种脑控制的人工声道再次说话。”

另一位研究者Anumanchipalli补充说:“我很自豪能够将神经科学,语言学和机器学习的专业知识作为帮助神经残疾患者,这是一个重要的里程碑。”

话题:

0

推荐

财新博客版权声明:财新博客所发布文章及图片之版权属博主本人及/或相关权利人所有,未经博主及/或相关权利人单独授权,任何网站、平面媒体不得予以转载。财新网对相关媒体的网站信息内容转载授权并不包括财新博客的文章及图片。博客文章均为作者个人观点,不代表财新网的立场和观点。

京公网安备 11010502034662号

京公网安备 11010502034662号