编译:杨威

对于许多人来说,人脸识别已经迅速从技术创新阶段转变为生活使用,因为全世界至少有数百万人愿意忍受机场、iPhone或Facebook应用场景中用软件扫描他们的面孔。

但最近纽约大学AI Now研究所的研究人员发出强烈警告,不仅针对如今无处不在的人脸识别应用,还有其更邪恶的表亲:所谓的情感识别技术。该技术可以通过你鼻子的形状,嘴巴的轮廓和你微笑的方式找到你内心隐藏的信息。

这听起来像是来自从19世纪开始挖掘的理论,确实如此。

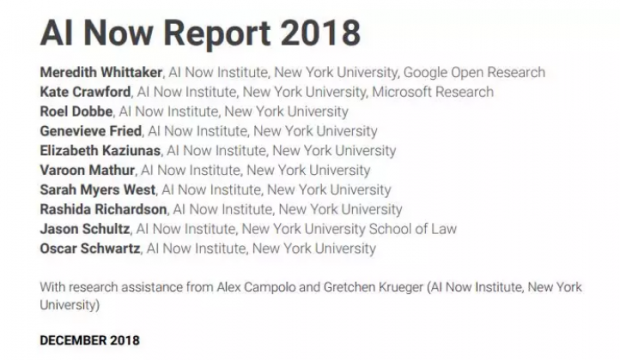

AI Now日前发布了一份长达56页的2018年AI发展报告,重点说明了人工智能发展过程中的重大问题。其将“人工智能”称为,一个包含众多学科尝试模拟人类判断和营销炒作的总称——在没有监管且有效的道德审查的情况下持续发展。

该报告重点论述了人工智能领域众多被广泛使用和滥用的行为,包括种族歧视、警察监视以及商业秘密法如何隐藏AI监督公众中的争议代码。

AI Now于去年成立,旨在解决人工智能的社会情感问题,在这篇新发布的报告中,重点表达了人们对情感识别的恐惧和担忧。

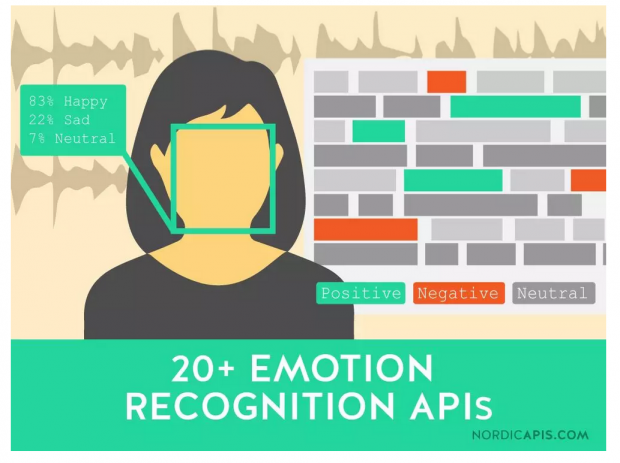

作为人脸识别的一个子学科,情感识别可以基于人脸图像或视频检测(发现)其个性,内心感受,心理健康情况。

想象一下,你的老板通过使用机器学习相机来不断评估你的工作精神状态,警察基于你的面部“微表情”,借助“情感识别”技术来推断你未来的犯罪行为……

“利用机器视觉和海量数据分析技术来发现事物相关性的能力将会引发一些可怕的结果。”

报告解释说,这是因为“情感识别”技术只不过是人相的计算机化,是一种来自另一个时代被揭穿的伪科学,即一个人的性格可以从他们的身体 - 尤其是他们的面孔中辨别出来。

在19世纪80年代,这一理论还每被认为是伪科学,后来,声名狼藉的意大利犯罪学家切萨雷·隆布罗索(Cesare Lombroso)推动了这一理论,今天很多人开始相信它是对的了:它缺乏科学基础,但很多人认为它是一个有吸引力的想法。

而如今数据导向型的公司已经抓住这个机会,不仅将名字与面孔关联,甚至将人的整个行为模式和预测归结为眉毛和鼻子之间的某种无形关系,而这种关系能通过计算机的“眼睛”来破译。

早在两年前,上海交大的学生发表的一篇论文称他们发明了一种仅根据人脸特征识别犯罪行为的机器学习算法。这篇论文受到了业界的广泛批评,其中包括AI Now的Kate Crawford,他告诉The Intercept它构成的文字颅相学......的依据只是使用现代的监督机器学习工具而不是“卡尺”。

Crawford以及她的同事比以往更加反对这种基于文化和科学的回归算法预测的传播。报告称 “虽然人相学以及与其关系密切的纳粹种族“科学”失去地位,但是研究人员仍然担心人相学的思想会在情感识别应用中死灰复燃。

“AI系统能够告诉我们学生、客户或犯罪嫌疑人的真实感受或者他们本质上是什么类型的人,这种思想对公司和政府非常具有吸引力,尽管这种主张的科学理由非常值得怀疑,但其差别对待的历史也被较好的记载。”

在一封致The Intercept的电子邮件中,Crawford(AI Now联合创始人兼纽约大学的杰出研究教授)与Meredith Whittaker(AI Now联合创始人兼纽约大学杰出研究科学家)通过介绍两家利用外貌特征来得出关于人的重大结论的公司为例子(反例),解释了为什么情感识别在当下的发展比以往更令人担忧。

Crawford 认为,从Faception公司声称他们可以通过人脸识别恐怖分子到 HireVue公司 通过分析面试过程中录制的面试者的面部微表情以预测他们将来是否会成为一名优秀的员工,使用机器视觉和大规模数据分析挖掘事物相关性的能力将会引发一些非常令人疑惑的主张。

Faception 据称可以从外貌上确定某人是否“心理上不平衡”、焦虑或有魅力,而HireVue则在相同基础上对求职者进行排名。

与一些自动化的、无形判断和决策的计算机系统一样,情感识别技术出现错误分类、标记的可能性是非常大的,特别是在基于薄弱科学基础的情况下:“这些被系统描述的人如何竞争结果”,Crawford补充道。

当我们依靠“黑盒子”AI系统识别人类的内在生活或价值时将会发生什么?其中一些产品引用了极具争议性的理论,这些理论在心理学文献中长期存在争议,但却被人工智能创业公司视为事实。

更糟糕的是,科学对摄像机范围内的任何人做出判断的是,制定这些决策的算法由算法开发公司保密,且不受商业秘密的严格审查。AI Now的Whittaker指出公司机密正如被混淆了的且问题累累的情感识别实践:因为大多数这些技术都是由私人公司开发的,这些公司是根据公司保密法运作的,报告强烈建议保护这些技术中的道德举报者。

Whittaker写道,这样的举报至关重要,因为许多数据公司将隐私和透明视为一种责任,而不是一种美德。虽然理由各不相同,但大多数[人工智能开发人员]不承担所有责任,并且要由客户决定如何处理它。伪科学与最先进的计算机工程相结合,并且没有问责制。怎么可能出错?

相关报道:

https://theintercept.com/2018/12/06/artificial-intellgience-experts-issue-urgent-warning-against-facial-scanning-with-a-dangerous-history/

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号