阅读:0

听报道

编译:小蒋、lvy、王嘉仪

经过了多波浪潮的人工智能这次能够有新的突破吗?还是,历史依然会重演呢?岁末年初,本文作者Thomas Nield从历史上的英国讲起,进而探讨了人工智能到底是什么,以及这一波人工智能浪潮又有哪些不同。

许多人认为算法将会超越人类的认知意识:机器可以在没有人为干预的情况下辨别和学习任务,并将大规模地替换掉工人;他们完全可以“思考”;许多人甚至提出了我们是否可以将机器人作为配偶的问题。

但这不是什么新颖的想法,早在20世纪60年代,当时的人工智能先驱Jerome Wiesner、Oliver Selfridge和Claude Shannon已经很坚信,这种情况会在不久的将来发生。

快进到1973年,AI的炒作给英国带来了适得其反的结果。

在这种AI热潮下,英国议会不会无动于衷,他们委任当时的人工智能专家,James Lighthill爵士撰写一份英国的AI研究现状报告。

在这份研究报告中,James Lighthill非常激烈地批评了当时被给予厚望的人工智能研究。Lighthill还指出,专业程序(或人)是如何比他们的“AI”同行表现得更好的。

这份报告被称为Lighthill Report,也正因为这份报告,当时的英国政府取消了所有人工智能研究经费(英国的研究在20世纪80年代再次兴起,Alvey项目是对日本的第五代计算机项目的回应)。

点击查看当时关于Lighthill报告的辩论

同一时间在大西洋彼岸,美国国防部在人工智能研究上投入了大量资金,随后由于同样的挫折,几乎取消了所有资金:人工智能能力的夸大,高成本且无回报,以及在现实环境中价值前景存疑。

在20世纪80年代,日本积极尝试用第五代计算机项目大胆刺激“AI”。然而,这最终也是一次耗资8.5亿美元的失败。

第一轮AI寒冬

20世纪80年代末迎来了第一轮AI寒冬。这是计算机科学的一个黑暗时期,组织和政府面临“人工智能”研究失败和沉没成本,也由此导致人工智能研究停滞了数十年。

到了1990年代初,“AI”变成了一个肮脏的词,这一状况持续到了2000年。人们普遍认为“人工智能不起作用”。编写看似智能程序的软件公司使用了“搜索算法”、“业务规则引擎”、“约束求解器”和“运筹学”等术语。值得一提的是,这些宝贵的工具确实来自人工智能研究,但由于未能实现更宏大的目的,它们现在被重新命名。

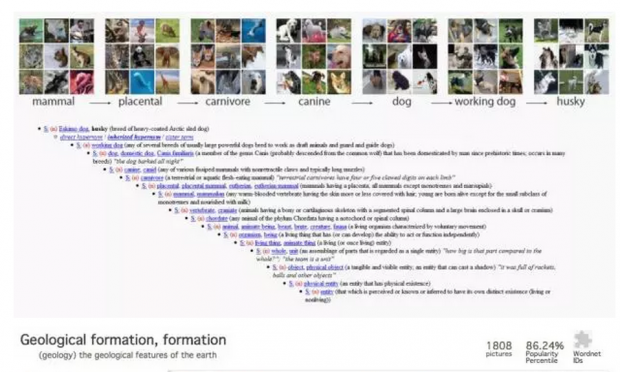

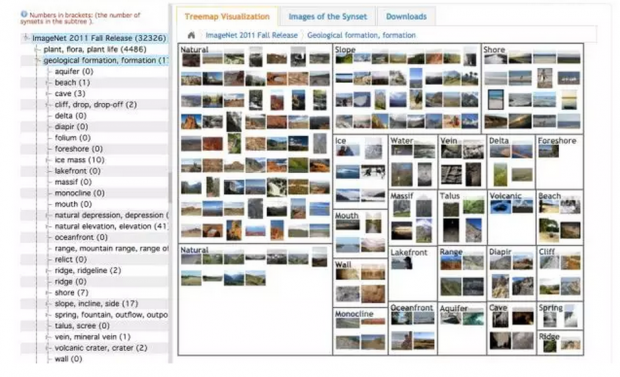

但在2010年左右,情况开始发生变化。人们对AI的兴趣再次迅速增长,关于图像分类的竞赛引起了媒体的关注。硅谷第一次通过使用足够大的数据使神经网络发挥作用。

到2015年,“AI”研究获得了许多财富500强企业的巨额预算。通常情况下,这些公司是由FOMO(fear of missing out)驱动而不是实际的案例,担心他们会被自动化的竞争对手所抛弃。毕竟,让神经网络识别图像中的物体真是令人印象深刻!对于非专业人士来说,SkyNet的能力肯定是下一个。但这真的是迈向真正的人工智能的一步吗,或者是历史重演?

什么是AI?

很长一段时间,我一直不喜欢“人工智能”这个词。

它太模糊且深奥,这还更多的是由营销人员而不是科学家定义的。当然,市场营销和流行语可以说是促进改变和接受新思维的必要条件。然而,流行语的混杂不可避免地导致了混乱。我的新华硕智能手机就被称作具有“AI铃声”功能,而也就是可以动态调整铃声音量,使其在环境噪音中足够响亮。我猜想一些可以用一系列“if”条件或简单的线性函数进行编程的东西,都被称为“AI”。

有鉴于此,“AI”的定义受到广泛争议也就不足为奇了。我喜欢Geoffrey De Smet的定义,该定义指出AI解决方案适用于具有不确定性答案和/或不可避免的误差范围的问题。这将包括从机器学习到概率和搜索算法的各种工具。

也可以说人工智能的定义不断发展,只包括突破性的发展,而过去的成功(如光学字符识别或语言翻译)不再被视为“AI”。所以“人工智能”可以是一个相对术语,而不是绝对的。

近年来,“AI”经常与“神经网络”联系在一起,这也是本文将重点关注的问题。还有其他“AI”解决方案,从其他机器学习模型(朴素贝叶斯,支持向量机,XGBoost)到搜索算法。然而,神经网络可以说是目前最热门的技术。

人工智能的“复兴”?

2010年之后,人工智能的兴起仅仅是掌握了一类新的任务:分类。更具体地说,由于神经网络的存在,科学家已经开发出有效的方法来分类大多数类型的数据,包括图像和自然语言。即使是自动驾驶汽车也是分类任务,其中周围道路的每个图像都可以转化为一组离散动作(加油,刹车,左转,右转等)。如果想要简单了解其工作原理,请观看这个如何制作一个视频游戏的AI的教程。

在我看来,自然语言处理比纯粹的分类更令人印象深刻。很容易相信这些算法是有感知的,但如果你仔细研究它们就可以说它们依赖于语言模式而不是有意识构建的思想。

谷歌Duplex可能是最令人印象深刻的自然语言处理技术,它允许你的安卓手机替你拨打电话,特别是预约什么。谷歌训练、结构化、甚至可能硬编码了“AI”。可以肯定的是,假呼叫者听起来自然有停顿。有“啊”和“嗯”......但是,这也是通过对语音模式的操作来完成的,而不是实际推理和思考。

这一切都非常令人印象深刻,而且肯定有一些有用的应用程序。但我们确实需要调整我们的期望并停止炒作“深度学习”的能力。如果我们不这样做,我们可能会发现自己处于另一轮的AI寒冬。

历史总在重演

纽约大学的Gary Marcus写了一篇关于深度学习局限性的文章,并提出了几个令人警醒的观点(在文章传播开之后,他又写了一篇同样有趣的续篇)。Rodney Brooks将时间线放在一起,并通过引用的研究跟踪他的AI炒作周期预测。

对此持怀疑态度的人通常有几个共同点。神经网络需要的数据量非常大,即使在今天,数据仍然是有限的。这也是为什么你在YouTube上看到的“游戏”AI示例通常需要几天不断地输掉游戏,直到神经网络找到对应的获胜模式。

我们确实需要降低我们的期望并停止夸大“深度学习”的能力。如果我们不这样做,我们可能会发现即将又会迎来AI的另一个寒冬。

神经网络“深度”是在于它具有多层节点,而不是因为它对问题产生了深刻的理解。这些层也使神经网络难以理解,对于开发人员也是是如此。最重要的是,当神经网络进入其他问题空间时,例如旅行推销员问题,它会出现回报递减的问题。为什么在搜索算法更加直接、有效、可扩展且经济的情况下,我还要使用神经网络来解决旅行商问题呢?

当然,有些人希望使用神经网络解决更多其他复杂的问题,虽然这很有趣,但神经网络似乎很难超越任何专门的算法。

Luke Hewitt 在《The Unreasonable Reputation of Neural Networks》文章中给出了最好的解释:

凭直觉在单项任务上判断机器有多高的智能或有多大的能力不是好事。20世纪50年代玩跳棋的机器让研究人员惊奇,许多人认为这是人类层面推理的巨大飞跃,但我们现在意识到,在这个游戏中实现人类或超人的表现远比实现人类一般智能要容易得多。事实上,即使是最优秀的人也很容易被简单的启发式搜索算法打败。在一项任务中,人类或超人的表现并不一定是在大多数任务中接近人类表现的垫脚石。

需要指出的是,神经网络需要大量的硬件和软件才能进行训练。对我来说,这是不可持续的。当然,神经网络的预测精度比训练时要高得多。然而,为了提高神经网络的精度,它需要不断的被训练,因此训练时消耗的能量和成本成指数级增长。当然,现在计算机的速度越来越快,但芯片制造商能否继续维持摩尔定律呢?

这是有道理的。为什么在搜索算法更加直接、有效、可扩展且经济的情况下,我还要使用神经网络来解决旅行商问题呢?

正是由于这些原因,我认为另一个AI寒冬即将来临。越来越多的专家和博主正在指出这些局限。公司依旧花费大价钱招聘最好的“深度学习”和“人工智能”人才,但我认为许多公司认识到深度学习并不是他们所需要的只是一个时间问题。更糟糕的是,如果你的公司没有Google的研究预算、博士人才或从用户那里收集的海量数据,你很快就会发现你实际的“深度学习”前景非常有限。

在每一个人工智能的寒冬之前,科学家们都在夸大和鼓吹他们创造的潜能。仅仅说他们的算法能很好地完成一项任务是不够的,他们希望它能解决任何任务,或者至少给人一种它可以的印象。例如,AlphaZero特别擅长于下棋,于是媒体的反应是“哦,天哪,通用智能时代来了!机器人来了!”然而科学家们并没有去纠正它们,而是鼓励他们使用这些词汇。毕竟,降低预期并不能帮助风投融资。但是,尽管人工智能研究人员的机器人能力有限,但他们仍然将算法拟人化,他们为什么会这么做呢,这比起科学问题,倒更像是一个哲学问题。

接下来会面临什么呢?

当然,并不是所有使用“机器学习”或“人工智能”的公司实际上使用了“深度学习”。

一个好的数据科学家可能被雇佣来构建一个神经网络,但当她真正研究这个问题时,她觉得构建一个朴素的贝叶斯分类器可能更合适。对于那些成功使用图像识别和语言处理的公司来说,他们将继续钻研下去。但我认为神经网络并没有在这类问题空间以外的地方取得进展。毕竟,缓和预期对风投融资没有帮助。

过去的人工智能寒冬在推动计算机科学的发展方面是毁灭性的。但是人工智能研究确实产生了一些有用的东西,比如搜索算法可以在国际象棋中夺冠,也可以将运输问题的成本最小化。简单来说,创新性的算法往往只擅长于一个特定的任务。

我想说明的是,许多问题都有都有很多相对应的有效的解决方案。为了不在人工智能的寒冬中冻死,你最好专注于你想要去解决的问题并且理解它的本质。在这基础上,为这个特定问题提供一个直观的解决方案路径。如果你要对文本消息进行分类,可能需要使用朴素贝叶斯分类器。如果你试图优化你的运输网络,可能需要使用离散优化。不管周围的研究者怎么说,你都可以对卷积模型持有怀疑态度,并质疑它的理论是否正确。

如果你不认同毕达哥拉斯派的哲学,那么你能想到的最好方法就是让人工智能“模拟”一些行为,创造出它产生了情感和思想的错觉。

希望这篇文章能让你清楚的意识到,深度学习并不是解决大多数问题的正确方法。不要为所有问题寻求一个通用人工智能解决方案,因为你不可能找到的。

哲学vs.科学

我想在这篇文章中提出的最后一点是,这个问题比科学更具有哲学意义。我们的每一个想法和感觉都仅仅是一堆数字以线性代数的方式被乘法和加法吗?难道我们的大脑仅仅是一个神经网络,整天只是在做点积吗?这听起来像是毕达哥拉斯的哲学把我们的意识降维到了一个数字矩阵。也许这就是为什么如此多的科学家相信通用人工智能是可能存在的,因为人类和计算机没有什么差别(我只是在这指出了这一点,并不是评论这个世界观是对还是错)。

不管周围的研究者怎么说,你都可以对卷积模型持有怀疑态度,并质疑它的理论是否正确。

如果你不认同毕达哥拉斯的哲学,那么你能想到的最好方法就是让人工智能“模拟”一些行为,创造出它产生了情感和思想的错觉。翻译程序并不懂得中文,只不过它可以通过寻找概率模式来“模拟”理解中文的假象。当你的智能手机“识别”狗狗的图片时,难道它真的能识别出狗狗吗?还是它只是看到了它以前学习过的数字模式?

相关报道:

话题:

0

推荐

财新博客版权声明:财新博客所发布文章及图片之版权属博主本人及/或相关权利人所有,未经博主及/或相关权利人单独授权,任何网站、平面媒体不得予以转载。财新网对相关媒体的网站信息内容转载授权并不包括财新博客的文章及图片。博客文章均为作者个人观点,不代表财新网的立场和观点。

京公网安备 11010502034662号

京公网安备 11010502034662号